Revista Iberoamericana de Derecho, Cultura y Ambiente

RIDCA - Edición Nº8 - Derecho Penal y Criminología

Alberto Pravia Director

Diciembre de 2025

El uso de “deep fakes” en el proceso electoral y la erosión del sistema democrático en la sociedad de la desinformación.

Análisis del delito de inducción a engaño en el Código Nacional Electoral y la creación de contenido sintético mediante la Inteligencia Artificial generativa

Autor. Gustavo Eduardo Aboso. Argentina

Por Gustavo Eduardo Aboso[1]

El uso de las nuevas tecnologías aplicadas a la comunicación significó un avance sin precedentes desde la creación de la imprenta en 1440.[2] Sin embargo, los enormes beneficios que trajo aparejado para la humanidad la implementación de la comunicación digital se vieron oscurecidos por el abuso o la aplicación para la comisión de delitos. En la actualidad, las tecnologías emergentes y, en especial, la inteligencia artificial generativa, han inaugurado un nuevo capítulo en la criminalidad informática mediante la generación de la llamada “realidad virtual” que incluye de manera preeminente el uso de deep fakes con fines delictivos. En este trabajo nos abocaremos a analizar la creación de representaciones alteradas de políticos prominentes o candidatos a nivel nacional e internacional con el objeto de difundir noticias falsas que tienen un efecto negativo en el normal desarrollo de los comicios electorales.[3]

Previo a introducirnos en el tema resulta apropiado matizar el uso de los términos que se habrán de emplear en este trabajo, ya que si bien se suele diferenciar de manera apropiada las “fakes news” o noticias falsas de la “deep fakes” o contenido sintético creado a partir de la intermediación de sistemas de algoritmos basados en inteligencia artificial generativa (IA)[4], en la práctica cotidiana social la diferenciación carece de una significación funcional, ya que las “fake news” adquieren distintas formas y se canalizan por múltiples medios de difusión en los que la injerencia de la inteligencia artificial resulta preponderante. En todo caso, ambas prestan buenos servicios al objetivo del proceso de desinformación enfocado a la alteración de la opinión pública y los comicios mediante la proliferación de posturas ideológicas radicalizadas y el flujo de información falso que conduce a la polarización política más extrema, afectando así al debate democrático y socavando de manera progresiva la confianza de la sociedad en sus instituciones.[5]

La elección del objeto de nuestro análisis viene condicionado por la reciente resolución dictada por la Cámara Nacional Electoral en un proceso sustanciado contra el autor de la difusión en Facebook de dos vídeos falsos que contenían la representación alterada de un candidato durante la campaña electoral de 2021.[6] El afectado fue un candidato preelectoral a la banca de senador nacional por la provincia de Córdoba. El hecho imputado consistió en crear una noticia falsa integrada por la composición de imágenes audiovisuales de periodistas y del propio interesado en la que simulaban una entrevista que versaba sobre el supuesto pedido de aportes dinerarios a los empleados del Congreso Nacional para la financiación de la campaña electoral.

Mediante diligencias judiciales se pudo establecer que la difusión de este material alterado había sido obra de personal de una firma publicitaria que abusó de su acceso al sistema de administración de cuentas para crear, editar y cargar contenidos en una red social. A partir de ahí, creó una cuenta con un título específico a través de la cual publicó la falsa entrevista periodística con el candidato afectado. El objeto de esta conducta fue la de perjudicar electoralmente al precandidato a senador nacional, más allá de que no se pudo acreditar durante el proceso que esa acción haya estado promovida o fomentada por terceras personas.

La homologación del procesamiento de la acusada se basó en la infracción del artículo 140 del Código Nacional Electoral que sanciona al que “indujere con engaños a otro a sufragar en determinada forma o a abstenerse de hacerlo.”[7] Se trata de un delito de peligro abstracto, ya que no requiere para su constitución que efectivamente el elector haya votado en un sentido determinado o se haya abstenido de hacerlo, algo que resulta claramente incomprobable en principio por el derecho de secreto del voto (artículo 13 CEN) y la imposibilidad de saber a ciencia cierta si efectivamente el electorado con su voto perjudicó al candidato electoral. Por lo tanto, resulta correcto identificar el contenido de los intereses penalmente tutelados por la ley electoral con la transparencia y el normal desarrollo de los comicios[8] que se verían afectados por la difusión de noticias falsas que puedan alterar el resultado electoral y menoscabar la candidatura del afectado. También debe tenerse en consideración que esta clase de conducta fraudulenta afecta de manera directa al elector, ya que introduce falsas afirmaciones o apreciaciones sobre los candidatos que pueden influir en su ánimo al momento de sufragar.

Queda exento de nuestro objeto de estudio la relación intrínseca que existe entre los discursos de odio, el uso de contenido sintético y la libertad de expresión en el juego de los valores democráticos, ya que no resulta sencillo trazar un límite apropiado que permita desvincular el uso de las nuevas tecnologías aplicadas a la propaganda política, en especial, cuando se relaciona con temas de candente actualidad, en especial, la xenofobia y las críticas mordaces a la política migratoria o la seguridad pública frente al incremento de la criminalidad urbana.[9]

La estrecha vinculación entre el derecho de sufragio pasivo y activo con el fortalecimiento del sistema democrático[10] y la necesaria renovación de las autoridades ejecutivas y legislativas que componen dos de los tres poderes públicos bajo el amparo del sistema de pesos y contrapesos diseñado por nuestra constitución parece evidente[11], ya que la inducción engañosa durante el proceso electoral tiene la capacidad de alterar la voluntad popular y así menoscabar de manera fatal el sistema democrático. Más allá de que no existe un estudio definitivo que permita determinar con seguridad la influencia perniciosa de las noticias falsas en la opinión pública[12], pero su efecto negativo no debe ni puede ser menospreciado.

Entre los fundamentos del interlocutorio comentado, el tribunal de segunda instancia hizo una serie de considerandos sobre el sentido y el alcance de la figura de inducción a engaño electoral que resultan apropiadas para circunscribir la subsunción típica de la conducta enrostrada a la imputada. En principio, la acción típica consiste en inducir a otro, en este caso, al elector, a votar en una forma determinada o abstenerse de ello. La acción de inducir tiene acá un clara vocación de influir en el ánimo del elector sobre la elección de los candidatos, es decir, no exige la figura que el autor exhorta a no votar a tal o cual candidato o promover la candidatura de otro, sino que basta para el juicio de tipicidad que la difusión de la falsa representación en este caso sea idónea para crear el peligro típico (hipotético) de alterar el resultado de los comicios.[13] En consecuencia, el delito de inducción a engaño durante la celebración de un proceso electoral no exige que se haya materializado el engaño o fraude electoral, siendo suficiente que la inducción haya sido adecuada para generar el estado de duda o rechazo del candidato cuya imagen o representación ha sido alterada.

Cabe consignar que este delito está necesariamente asociado al desarrollo de un proceso electoral, por lo tanto, condición inexcusable para la comisión de este delito electoral será que el Poder Ejecutivo Nacional haya convocado y fijado la fecha para la elección que, de acuerdo al artículo 54 del CEN, no podrá ser menor a los noventa (90) días de anticipación. Esta condición temporal es importante para el juicio de tipicidad del delito electoral bajo análisis, ya que la difusión de deep fakes sólo tendrá relevancia típica cuando exista un proceso electoral en curso, de ahí que cualquier forma de difusión de material alterado fuera del plazo establecido será atípica para esta ley, más allá de que pueda menoscabar el honor del afectado.

El término “deep fake” combina dos elementos que permiten conceptualizar de manera integral cuál es su alcance y sentido, ya que se origina en la yuxtaposición del uso de la IA generativa (deep learning) y la calificación de falsa o mendaz de la información (fake). La tecnología aplicada a la generación de imágenes alteradas resulta factible gracias al uso de sistemas algorítmicos adversariales (Generative Adversarial Networks o GANs).[14] La imagen resultante mediante el uso de esta tecnología resulta muchas veces difícil de distinguir de una auténtica, in fortiori, cuando aporta mayor grado de realismo, circunstancia que coadyuva de manera decisiva a incrementar el cuadro de confusión y favorecer el esparcimiento de la información falsa. El uso de herramientas digitales aplicadas a la difusión de noticias falaces está bien documentado y ha tenido un efecto negativo en los procesos eleccionarios, por ejemplo, como suele citarse, en el caso de la elección presidencial de 2016 en los Estados Unidos o la del actual presidente francés Emmanuel Macron en los comicios de 2017 mediante la difusión de supuestos documentos clasificados.[15]

Una vez finalizado el comicio (artículo 100 del CEN), la difusión de representaciones falsas de un candidato resulta atípica, ya que ha concluido el acto electoral y de ahí la posibilidad de influir sobre los electores.

Respecto de los medios comisivos, la figura en análisis no establece un medio determinado ni se restringe al uso de los medios digitales, algo que en nuestro tiempo resulta ser el canal por excelencia para la perpetración de este delito. El uso de la tecnología monopolizó la forma de expresión en la comisión de este delito, ya que la capacidad de reproducción de material generado a caballo de la inteligencia artificial y su consecuente realismo difícilmente puede ser superado por otras formas de engaño, sumado a que el uso del entorno digital favorece de manera decidida la impunidad gracias a la creación de falsos perfiles de usuarios en las redes sociales que muchas veces hacen imposible la trazabilidad de la fuente primaria. En consecuencia, la posibilidad de cometer este delito se agiganta cuando un usuario comparte este material con otros, aunque seguramente no haya sido el creador de la deep fake, por ejemplo difundiendo la falsa representación a través de su cuenta en la red social.

Esta situación genera a su vez una relación de tensión con la libertad de expresión y, en particular, con el debate público que se origina en torno de los procesos electorales. ¿Cuándo una noticia puede ser considerada falsa? Es algo habitual que durante el comicio electoral se reproduzcan incontables vídeos o noticias falsas sobre los candidatos, incluso muchas de ellas son difundidas por los medios de comunicación masivos y el candidato afectado salga a aclarar que esa noticia es falsa y malintencionada. En la mayoría de los casos también ocurre que la deep fake mediante la representación alterada de la imagen audiovisual del candidato sea burda y objetivamente puede apreciarse su contenido falaz por parte del público.

El juicio de tipicidad del delito de inducción engañosa durante el proceso electoral quedará suspendido cuando se avise al público que se trata de una falsa reproducción, siempre y cuando su contenido no haya incluido la comisión de delito o una inconducta ética en el ejercicio de las función pública. Si aparece reproducida la imagen audiovisual de un candidato en un reel en Instagram que fue generada a través del uso de las nuevas tecnologías y su carácter es esencialmente jocoso, es decir, busca divertirse a expensas del candidato sobre alguna cuestión vinculada con un asunto de interés público, entendemos que esta clase de reproducciones quedan extramuros del ámbito de aplicación de esta figura delictiva.

Recuérdese que el uso de la sátira ha sido considerado de manera inveterada como una forma aceptada en el ejercicio de la libertad de expresión.[16] Siendo consecuente con esta premisa, debería excluirse del ámbito de aplicación del tipo penal del delito de inducción fraudulenta electoral todo la constelación de supuestos en los que se efectúa una crítica razonable del candidato y/o sus propuestas electorales en el marco del ejercicio de la libertad de expresión y el fortalecimiento del debate sobre asuntos de interés público.

Una situación análoga se presentó en el proceso sustanciado contra un humorista político que empleó la inteligencia artificial generativa para crear contenido sintético en el que distintas figuras políticas aparecen representados en situaciones hilarantes. El acusado empleó su cuenta de usuario en distintas redes sociales para difundir su trabajo.[17] Cada una de sus representaciones estaban etiquetadas de manera clara alertando al observador de su falsedad. El gobernador de California se quejó de una de las representaciones sintéticas en las que aparecía retratada de modo caricaturesco la ex candidata Kamala Harris y sostuvo que esa actividad debía ser considerada como ilegal.[18] Debe aclararse al lector que en el estado de California existe una regulación específica en materia electoral que prohíbe la difusión de contenido engañoso (“materially deceptive content”).

Nos referimos a la disposición AB 2839 de la California Election Law sancionada el 17 de septiembre de 2024 y que establece la prohibición de realizar cualquier tipo de publicidad electoral engañosa dentro del plazo de 120 días previos a la fecha del comicio y que se extiende a otros 60 días posterior a él. La norma de naturaleza civil fija el contenido de la materia de prohibición al determinar que los sujetos tutelados son los candidatos nacionales, estaduales o municipales, es decir, los tres niveles de gobierno. A su vez, el material modificado alcanzado por esta ley consiste en afirmaciones mendaces en relación con una elección en ese estado y cuyo contenido sea idóneo para debilitar la confianza en el resultado mediante el uso de medios audiovisuales.

En particular, la ley excluye de su aplicación, en su párrafo tercero, el contenido mordaz o satírico, siempre y cuando esta circunstancia haya sido debidamente aclara al agregar la frase: “Este ____ ha sido manipulado con fines satíricos o paródicos.”

El término “deep fake” acuñado en la ley se define como “un medio de audio o visual creado o modificado digitalmente de manera tal que a una persona razonable le parecería falsamente un registro auténtico del discurso o la conducta real del individuo representado en el medio.”

Regresando al proceso sustanciado contra el humorista político demandado, su defensa expresó que la disposición era muy genérica y vaga en su descripción, sumado a que infringía la libertad de expresión, máxime cuando su contenido sintético no era lesivo para terceros. El tribunal analizó en primer término la moción de inconstitucionalidad de la ley a la luz de las objeciones presentadas por el demandado y concluyó que, más allá de reconocer el peligro creciente de la aplicación de los medios tecnológicos para provocar la desinformación, ella actúa como un “martillo” en lugar de un bisturí al prohibir ciertas formas de expresión, entre ellas la humorística, que conduce a la restricción irrazonable de la libertad de expresión. Se afirmó que los principios que guían la protección extensa de la libertad de expresión no han variado con la irrupción de las nuevas tecnologías y así evitar que el discurso político no sea censurado por sus ideas, contenidos o temas.

Por el contrario, cuando la reproducción digital apunta de manera unívoca, es decir, a sabiendas, a provocar el error en el sufragante mediante la difusión de hechos mendaces y así influir de manera negativa en la posible elección de un candidato, aunque con ello no se pretenda favorecer a otro, queda abierta la posibilidad de apreciar la configuración del delito analizado.

Resta discutir cuál debería ser la naturaleza y el contenido falaz, ya que no toda mentira es apta para provocar engaño suficiente en el electorado. Por ejemplo, en el interlocutorio mencionado el contenido de la información se vinculaba con la financiación de la campaña del candidato originada en el aporte dinerario de una parcela de los sueldos cobrados por el personal asignado en el Congreso Nacional. La información era mendaz, ya que no existía denuncia o proceso penal que avalase este hecho, por lo tanto, la justicia electoral aplicó de manera adecuada el principio de especialidad para legitimar su intervención en detrimento de la eventual comisión de un delito de calumnias (artículo 109 del Código Penal).

Esta práctica desleal y criminal que persigue la inducción a error a los votantes no es patrimonio local, sino que también se extiende a otras latitudes, en especial, las últimas elecciones presidenciales en los Estados Unidos han estado teñidas de controversias sobre el uso de la inteligencia artificial para la generación de deep fakes. Esta nueva tecnología también ha sido aplicada para crear discursos de odio, por ejemplo, el que protagonizó de manera involuntaria el alcalde de Londres, Sadiq Kahn, cuando se difundió un vídeo modificado en el que aparecía criticando una marcha pro palestina y fomentando la lucha violenta.[19]

Uno de los primeros casos de utilización de contenido sintético falaz para alterar un proceso electoral fue el caso de la elección parlamentaria en Eslovaquia de 2023. Las dos principales fuerzas políticas que competían en el comicio representaban la polaridad que existe en Europa entre las esferas de influencia entre la Unión Europea y Rusia, teniendo como trasfondo el conflicto bélico ruso-ucraniano. A través de las redes sociales se propagó un vídeo falso en el que se registraba a una de las candidatas en contra de los intereses rusos manteniendo una entrevista con un periodista en el que reconocía un caso de fraude electoral. La candidata afectada salió enseguida a desmentir la autenticidad del audio, pero el daño ya estaba hecho porque la difusión del vídeo alterado se realizó durante la veda electoral, lo que limitó seriamente la posibilidad de negar su autenticidad y derivó en su derrota electoral.[20]

La interferencia de agentes extranjeros en elecciones nacionales está bien documentada en el llamado “Informe Mueller” elaborado por el Departamento de Justicia de los Estados Unidos y publicado el 18 de abril de 2019 que comprobó la intervención de una agencia rusa, Internet Research Agency (IRA), con sede en San Petersburgo, financiada por un oligarca de ese país y con conexión directa con la autoridad ejecutiva nacional, cuya tarea principal fue la de utilizar cuentas en las redes sociales para desperdigar información falsa en el entorno digital con el objetivo principal de fomentar la división social y sembrar cizaña en la población. Según el contenido del informe, las actividades de desinformación tuvieron como meta perjudicar la campaña electoral de Hillary Clinton y favorecer al por aquel entonces, actual presidente en su segundo mandato, Donald Trump. La interferencia en el proceso electoral estadounidense incluyó el acceso no autorizado a cuentas de miembros del equipo de campaña de la candidata demócrata y la difusión a través de distintos portales de información falsa sobre la conducta de la candidata demócrata.[21]

El citado informe no acusó a Trump por obstrucción de la justicia en la investigación llevada a cabo, pero tampoco lo absolvió sobre su participación directa o indirecta en la comentada interferencia extranjera en el proceso eleccionario, pero todo esto cayó pronto en el olvido, ya que el informe fue duramente criticado por los opositores del actual presidente.[22]

El contenido del material sintético generado por los sistemas de algoritmos basados en inteligencia artificial puede ser muy variado. Desde asuntos sexuales, escándalos financieros u opiniones discriminantes hacia las minorías, así como la falsa asunción de una postura política, casi todos los candidatos a elecciones en el último tiempo han sido víctimas frecuentes de este tipo de ataques a su integridad personal y reputación social. Sólo por citar algunos casos para ejemplificar el alcance de la difusión de falsa información, el actual presidente de los Estados Unidos ha sido difamado de manera reiterada mediante la creación de falsas entrevistas o posteos en los que acepta de manera abierta haber manoseado a mujeres[23], incluso su participación activa en escándalos sexuales (caso Epstein).[24]

La tecnología aplicada a la creación de vídeos alterados recurre a contenidos auténticos de la persona afectada y así reordena de manera sintética las expresiones, la forma de hablar, los movimientos y el discurso orientado hacia los parámetros ingresados al sistema por parte del solicitante. El sistema requiere del aporte de una cantidad sustancial de datos compuestos por imágenes y sonidos de la persona cuya representación se quiere compaginar. El costo y el tiempo para generar este tipo de representaciones alteradas puede variar según el mayor o menor grado de complejidad de su contenido.[25]

La clonación de la voz mediante el uso de aplicaciones diseñadas ex profeso resulta ser un recurso cada vez más frecuente para cometer ilícitos, quizá el más conocido sea el del gerente general de una compañía de energía cuya voz fue clonada para autorizar una transferencia electrónica de dinero de la cuenta bancaria abierta en una entidad húngara por varios cientos de miles de euros.

Pero también la clonación de voz sirvió para reproducir de manera mendaz un mensaje de audio del expresidente Biden exhortando a sus votantes para no participar de las elecciones primarias en el estado de New Hampshire. Esta situación se materializó dos días antes de la fecha del comicio y obligó a intervenir a la autoridad federal en materia de comunicaciones para determinar el origen de la “deep fake”. Tanto la empresa prestadora del servicio de comunicación (Lingo Telecom) como un individuo fueron formalmente sumariados por este hecho de suplantación de identidad (“spoofing”). De acuerdo a la investigación llevada a cabo por el organismo competente, se utilizó un programa de llamado automático (“robocall”) para reproducir el mensaje grabado falso del expresidente.[26]

Otra herramienta técnica es la de alterar el contenido gráfico mediante la generación de textos. De esta manera se crea un discurso hecho a la medida del contexto general de la representación modificada con el objeto de transmitir una opinión desfavorable sobre asuntos públicos o privados, se suele emplear para componer un discurso político adverso a los intereses del afectado, por ejemplo, manifestar su acuerdo con extender la guerra en algún conflicto actual o expresar directamente un discurso de odio.[27]

La tendencia progresiva de aplicar la inteligencia artificial para alterar o influir de manera negativa los procesos eleccionarios motivó a la Comisión Europea a dictar las Directrices de la Comisión para los prestadores de plataformas en línea de muy gran tamaño y de motores de búsqueda en línea de muy gran tamaño para la reducción de los riesgos sistémicos en los procesos electorales de conformidad con el artículo 35, apartado 3, del Reglamento (UE) 2022/2065.[28] El documento alerta sobre el peligro creciente de la difusión de los discursos de odio, contenidos violentos y extremistas, o directamente orientados hacia la desinformación de los electores.

La Comisión exhorta a las plataformas en línea y los motores de búsqueda a colaborar en la preservación de los procesos electorales, en especial, cuando hace unos años se llevaron a cabo varias elecciones simultáneas, entre ellas, las convocadas para renovar los escaños en el Parlamento europeo. La idea central gira sobre la necesidad de estrechar los lazos de cooperación entre la autoridad pública y las empresas privadas proveedoras de los servicios digitales con el objeto de reducir el riesgo latente de la difusión de esta clase de material audiovisual generado por la aplicación de inteligencia artificial.

Entre las medidas propuestas para reducir el peligro que se cierne sobre el ambiente digital, se promueve el refuerzo de los procesos internos de control sobre la información que circula en las redes sociales vinculadas con los partidos políticos, los candidatos, los programas de partidos, los manifiestos u otros materiales políticos, la convocatoria a manifestaciones partidarias, campañas, la recaudación de fondos, entre otras actividades.

Al mismo tiempo, la supervisión del estado de la libertad y el pluralismo de los medios de comunicación puede estar a cargo de organismos o instituciones privadas, por ejemplo, Media Pluralism Monitor, proyecto de investigación que evalúa la salud de los ecosistemas mediáticos en Europa, destacando las amenazas al pluralismo y la libertad de prensa en los Estados miembros de la Unión Europea y los países candidatos.[29]

En definitiva, las directrices comunitarias proponen: a) Acceso a la información oficial sobre el proceso electoral a los fines de evitar la manipulación de información o directamente la desinformación y la injerencia de agentes extranjeros; b) Propuestas de alfabetización mediática que consisten en colaborar en iniciativas y campañas de alfabetización mediática centradas en las elecciones, ponerlas en práctica, e invertir y participar en ellas con el fin de fomentar el pensamiento crítico y mejorar las capacidades de los usuarios en el reconocimiento de las técnicas de desinformación y manipulación, incluyendo las relacionadas con la IA generativa; c) Medidas para proporcionar a los usuarios más información contextual sobre el contenido y las cuentas con las interactúan (v. gr., etiquetas de verificación de datos, incitadores y acicates para instar a los usuarios a leer los contenidos y evaluar su exactitud y fuente antes de compartirlos; indicaciones de las cuentas oficiales claras, visibles y no engañosas; etiquetado de las cuentas claro, visible y no engañoso cuando estas estén controladas por los Estados miembros, terceros países y entidades controladas o financiadas por entidades controladas por terceros países; herramientas e información para ayudar a los usuarios a evaluar la fiabilidad de las fuentes de información; entre otros).[30]

Sobre el uso de las tecnologías emergentes asociadas con la IA generativa que constituye el objeto principal de nuestro estudio, las directrices le dedican un renglón aparte ya que se le reconoce como uno de los principales factores disruptivos en el proceso eleccionario. En particular se pone el énfasis en la generación de información falsa que puede inducir a error al elector o manipular los procesos electorales mediante la creación de contenidos sintéticos no auténticos, sesgados o engañosos, v. gr., de contenido audiovisual. El uso de algoritmos basados en inteligencia artificial permite generar una realidad alternativa, difusa y mendaz, generalmente conocida como “alucinaciones”, en las que los candidatos aparecen en situaciones irreales o expresando contenido fraudulento.

Entre las medidas preventivas que se aconsejan adoptar se cuenta el etiquetamiento de los contenidos sintéticos generados mediante IA, por ejemplo, las marcas de agua, es decir, identificación de metadatos, métodos criptográficos “para probar la procedencia y autenticidad del contenido, métodos de registro, impresiones dactilares u otras técnicas, según proceda, teniendo en cuenta las normas existentes. Esto último reviste especial importancia para cualquier contenido generativo de IA que afecte a candidatos, políticos o partidos políticos. Las marcas de agua y los metadatos también podrán aplicarse a contenidos basados en imágenes que, en un principio, fuesen auténticas (como vídeos, imágenes o audio), pero que posteriormente se hayan alterado mediante el uso de IA generativa.”

En los Estados Unidos se propusieron proyectos de reforma en aras de combatir la creación y la distribución de imágenes falsificadas o deep fakes generadas mediante el uso de las tecnologías emergentes. Por ejemplo, la Malicious Deep Fake Prohibition Act of 2018 impulsada por un senador propuso introducir reformas en el Capítulo 47 del Título 18 del United State Code que prohíbe el uso de deep fakes, que se definen como “registro audiovisual creado o alterado de manera, para un observador razonable, como un registro auténtico del discurso o la conducta de un individuo.” Además, se propone la sanción de la creación, la distribución, la facilitación o su tentativa de esta clase de material falseado con el objeto de cometer un delito. A este fin se prevé pena de multa o prisión, en este último caso de hasta dos años, pero que puede incrementarse a diez años cuando haya afectado cualquier procedimiento legislativo, electoral o judicial, o bien instigue a la violencia. Si bien la medida legislativa no prosperó, ella fue seguida por otras, incluso algunos estados han legislado sobre la materia y, en especial, el uso de esta tecnología para alterar o afectar el proceso electoral (California y Virginia).[31]

En este contexto de reforma, el proyecto conocido como Deep Fakes Accountability (2019) persigue la finalidad de proteger la seguridad nacional frente a la amenaza creciente de las representaciones alteradas y brindar recursos legales a las víctimas del abuso de la tecnología. Se propone agregar una modificación al Capítulo 47 del Título 18 del U. S. Code para castigar a “cualquier persona que, utilizando cualquier medio o facilidad de comercio interestatal o exterior, produzca un registro tecnológico avanzado de suplantación de identidad falsa con la intención de distribuir dicho registro por internet o con conocimiento de que dicho registro se distribuirá de esa manera (…).” El medio técnico debe ser un registro audiovisual alterado y la finalidad del autor la de humillar, acosar, causar violencia o daño físico a un tercero, incitar a un conflicto diplomático o militar, cometer fraude mediante suplantación de identidad o influir en el debate electoral o su proceso. Como consecuencia de la realización de cualquiera de las conductas descritas se establecen penas de prisión y multa. También se aseguran los derechos victimales mediante el ejercicio de la acción civil conjunta y se promueve el sistema de cogestión entre el gobierno y las empresas proveedoras de los servicios digitales al requerir la adopción de medidas preventivas idóneas para evitar la comisión de las infracciones mencionadas.[32]

Recientemente la Disrupt Explicit Forged Images and Non-Consensual Edits Act of 2024 (o su acrónimo “Defiance Act of 2024”) establece la reparación civil de las víctimas de esta forma de humillación digital. Las llamadas “deep fakes” abarcan las imágenes creadas de manera digital así como la adulteración de fotos reales mediante el uso de las tecnologías, aunque su ámbito de aplicación no se extiende a los procesos electorales.

Por su parte, los principales proveedores del servicio digital (Google, X, Facebook) no se han quedado inertes frente a la utilización de las plataformas como trampolín mediático para alterar o distorsionar los procesos electorales, como se ha verificado en varios países. Una propuesta que podríamos calificar sin duda de radical es la prohibición de publicar contenido político durante la celebración de los comicios electorales, lo que significa una pérdida abultada de aportes dinerarios. La política empresarial de estas plataformas ha estado bajo el escrutinio público y las críticas provenientes de distintos sectores de la sociedad y la autoridad pública sobre el control efectivo de los contenidos difundidos a través de las redes sociales generaron un cambio abrupto de la perspectiva del negocio digital.[33]

Acá podemos citar para graficar lo que queremos expresar la situación que se presentó en la última elección para diputados locales cuando se difundió a través de la red social X la baja de la candidatura de quien encabezaba la lista de su partido comunicada de manera falsa por uno de los jefes de la oposición, Mauricio Macri. Esta circunstancia generó la denuncia penal ante la justicia electoral local y se solicitó el cese inmediato de la difusión al proveedor de servicio digital que tiene ubicado sus servidores en extraña jurisdicción (Estados Unidos), aunque no sabemos a ciencia cierta si efectivamente eso sucedió o no.[34]

Pudo apreciarse sin ambages la falsedad del vídeo modificado, aunque es cierto que tuvo la capacidad comunicacional para inducir a engaño a los electores, sumado a que su difusión se produjo durante el mismo proceso electivo. En los albores de la investigación promovida por la denuncia del apoderado del partido afectado se pudo individualizar las cuentas de algunos de los usuarios de la plataforma social que replicaron el vídeo falso.

El Código Electoral de la Ciudad Autónoma de Buenos Aires (ley 6031) no regula una contravención asociada al uso indebido o engañoso de la inteligencia artificial generativa, como sí lo hace el Código Electoral Nacional cuando sanciona en su cuerpo normativo las faltas vinculadas con el ambiente digital como medio comisivo (artículo 128 ter), aunque lo hace de manera limitada porque se refiere de manera exclusiva a la publicidad, mas no a la engañosa o falsa.

Se debe recordar que la imputación del delito electoral desplaza la de la contravención en el ámbito local.[35]

No en vano este canal de comunicación digital, nos referimos a las redes sociales, es el vehículo por antonomasia para cometer infracciones a la ley electoral cuando rige la veda, ya que resulta imposible o, al menos muy dificultoso, ejercer un control efectivo y a tiempo de los contenidos sintéticos que se difunden de manera vertiginosa entre los usuarios. La detección es posible por parte de los administradores de los servicios digitales, pero la posibilidad de contener o impedir la distribución de esta clase de material fraudulento es prácticamente nula.

A la par de esto, hemos dicho que el artículo 140 del Código Electoral Nacional cuando describe el delito de inducción engañosa lo hace en el sentido de sancionar la inducción a otro a sufragar en determinada forma o a abstenerse de hacerlo, circunstancia que presenta un campo fértil para discutir cum grano salis la tipicidad de la difusión de una deep fake como la que protagonizó Macri, ya que el contenido realista y modificado del discurso no inducía a sufragar de una determinada forma (por ejemplo, a favor de un candidato, en blanco o anulando el voto) y menos aún a no hacerlo, que de por sí solo constituye una falta electoral (artículo 125 CEN).

Un aspecto controversial surge cuando los usuarios de una red social replican la “deep fake” amparándose en la libertad de expresión. Queda claro que la difusión o distribución de este tipo de material mediante su reenvío en el entorno digital o su publicación directa puede configurar el delito en comentario, pero también debe quedar suficientemente aclarado que la conducta de inducir requiere una finalidad determinada que no siempre puede comprobarse en un proceso penal. De hecho, la difusión de la “deep fake” en la que aparecía Macri bajando la candidatura de su principal postulante resulta claramente burda en su generación, ya que puede advertirse de manera clara su contenido sintético, incluso los propios medios de difusión masivo reprodujeron el vídeo durante la jornada electoral, lo que nos pone en la difícil disyuntiva de trazar un límite exacto entre el ejercicio de la libertad de expresión y de prensa frente al necesario resguardo de la transparencia del proceso y la observancia de la veda electoral.

Yendo de manera directa a la naturaleza y el contenido de la conducta de inducción, hemos dicho que esta figura se corresponde con los lineamientos teóricos del delito de peligro abstracto, ya que no se reclama un desvalor de resultado para su consumación, es decir, que efectivamente los electores hayan sido engañados por la deep fake. Pero también corresponde señalar que nuestra legislación punitiva no contempla la llamada “inducción en cadena”, ya que la inducción prevista en el artículo 45, in fine, del Código Penal refiere la determinación directamente a otro, por lo tanto, las reproducciones entre los ciberusuarios del contenido sintético puesto a disposición de un tercero como fuente primaria de la difusión impediría la aplicación extensiva o analógica de la ley penal.

Una solución alternativa ensayada en el derecho judicial comparado ha sido la de aplicar el criterio del dominio por organización y valorar como una forma de autoría mediata la inducción engañosa en la celebración de los comicios.[36] Sin embargo, esta solución dogmática viene de la mano de aceptar la autoría mediata como una forma de autoría punible, algo que en nuestra legislación todavía no está regulado en el citado artículo, más allá de que ella podría deducirse de los tipos de la Parte Especial, cuando ella fuera procedente. Por lo común, el que genera y difunde el contenido sintético sobre un candidato con el objetivo de causar engaño en el electorado no es el auténtico interesado, por lo tanto, la figura de inducción a engaño contemplada en el artículo 140 del Código Electoral Nacional sólo castiga al que difunde necesariamente el contenido engañoso, pero quien lo financia o es el verdadero beneficiado por la maniobra fraudulenta permanece entre las sombras. Como dijimos que la inducción en cadena no está prevista en nuestra legislación punitiva, la norma de conducta debería incluir de manera necesaria y respetando el principio de legalidad a los que financien, fabriquen o pongan a disposición de otro el material alterado para su difusión.

También debería incluirse una norma procesal que faculte al juez a ordenar la eliminación del contenido sintético y no dejarlo a la buena voluntad de los administradores de las plataformas digitales. La negativa o retardo en el cumplimiento de la orden judicial podrá dar lugar a la comisión de un delito de desobediencia (artículo 239 del Código Penal).

En una futura reforma sería conveniente incluir en el Código Penal un título autónomo que proteja el normal y correcto desarrollo de los procesos electorales, como acontece con el Strafgesetzbuch alemán (§§ 105 a 108f). El actual § 108a de este cuerpo normativo reprime el engaño al votante y consiste en provocar que el elector se equivoque mediante engaño en el contenido de su declaración de voto o que no vote o que vote de manera inválida contra su voluntad.[37] Este dispositivo se asemeja a nuestra figura de inducción a engaño, pero sería deseable una reforma integral que abarque las conductas asociadas a la maniobra fraudulenta de inducir a engaño a los electores, así como la inclusión expresa de las deep fakes y el deber de eliminar el contenido sintético cuestionado.

Por lo demás, aquellos usuarios que transmiten en redes sociales el contenido sintético falso podrán alegar con éxito que este material era burdo o bien que desconocía su naturaleza modificada, en cualquier caso lejos de iniciar una cacería de brujas que tendría un final incierto, la investigación penal debería estar orientada a la determinación de la fuente primaria y así individualizar al autor o autores. Claro que esto colisiona de frente con los tres factores que caracterizan a la red de redes que es el anonimato, la accesibilidad y la asequibilidad que hacen posible que el autor se esconda detrás de un falso perfil o la creación de cuentas falsas (o fantasmas) que permiten desperdigar el contenido sintético con un riesgo mínimo de ser descubierto.

Una propuesta de solución viene de la mano del modelo de cogestión entre el sector público y privado que se impone de manera gradual en otras latitudes para la prevención y la represión de los delitos o conductas disociales que se exteriorizan en el mundo digital (Internetkriminalität).[38] Esto requiere que los proveedores de los servicios en la sociedad digital actúen de manera proactiva para prevenir la comisión de delitos, por ejemplo, como ya se experimenta en el campo de la lucha contra el abuso y la explotación sexual infantil u otras áreas contiguas. Una solución intermedia sería la de que el propio administrador del servicio digital elimine la “deep fake”[39] como de hecho se lo ordenó el acusador público en el caso comentado más arriba, aunque los riesgos de la censura previa[40], pero esta vez administrada por el sector privado y oligopólico, también es un baremo a tener en cuenta en el cálculo de los límites a la libertad de expresión en un sistema democrático y pluralista.[41]

Esta exégesis primaria puede ser convincente, pero también resulta válido predicar que el vídeo de la mendaz baja de la candidatura de quien encabezaba la lista del partido gobernante en la ciudad autónoma importa una eventual alteración de los resultados del comicio al promover una modificación en el ánimo del elector sobre sus intenciones de voto, máxime cuando en nuestra realidad política existe una convivencia tensa entre las dos fuerzas gobernantes a nivel nacional y local.

Un proyecto de ley fue presentado recientemente por un grupo de legisladores que propone la incorporación del Capítulo IV ter en el Código Electoral Nacional dedicado a “la protección del Régimen Electoral frente a la desinformación generada por contenidos manipulados”.[42] Se incorporan definiciones sobre “contenido manipulado”, “contenido materialmente engañoso”, “plataforma digital de gran alcance”, entre otros; y se propone un sistema de colaboración forzoso con los proveedores de los servicios digitales en la tarea de eliminar los contenidos sintéticos engañosos, para lo cual se regula un procedimiento de eliminación de datos. En términos comprensivos, el contenido manipulado y engañoso debe representar un candidato diciendo o haciendo algo inventado y que tenga capacidad para inducir a error o socavar la transparencia del proceso eleccionario. El proyecto recepta el método del etiquetamiento de contenido para advertir al elector sobre lo fraudulento de la representación y deja fuera de su ámbito de aplicación el contenido publicado en medios periodísticos con la debida advertencia de su falsedad y el uso de la sátira política.

En términos generales el contenido del proyecto se asemeja a la legislación californiana a la que hemos hecho referencia y así puede hacerse también acreedora de las mismas críticas de las que fue blanco esa normativa a la luz del ejercicio de la libertad de expresión, ya que si bien parece que traza límites perceptibles entre el uso abusivo de las redes sociales y el derecho a la crítica como manifestación de la libertad de expresión, siempre existe el riesgo de crear una censura previa sobre el contenido de las ideas, opiniones y posturas ideológicas que caracterizan el quehacer democrático fruto del debate de ideas. Debe quedar suficientemente aclarado que cuando el contenido sintético fue creado con el único fin de su empleo engañoso para inducir a error al electorado, entonces sí parece plausible establecer mecanismos de reporte y eliminación de las representaciones o imágenes alteradas, pero el método del etiquetamiento aparece como una opción a tener en cuenta, aunque no la única.

Hemos restringido nuestro análisis al uso de las “deep fakes” en los procesos electorales, pero su aplicación no reconoce fronteras y sirve de manera fatigosa para incrementar la desinformación y la división social, en especial, cuando existe un sinnúmero de ciberusuarios que actúan de manera maliciosa y prestan sus servicios a intereses ajenos que promueven el odio, la discriminación y debilitan los pilares sobre los cuales se asienta el sistema democrático.[43]

A modo de colofón, resulta imperioso introducir una reforma integral en la ley electoral para sancionar este tipo de actividades orientadas hacia la desinformación del público mediante la creación de vídeos, imágenes, audios o el uso de chatbot para promover el extremismo político y generar mayor confusión en el electorado. También debería existir un compromiso en el sector político en el que sus principales actores rechacen la implementación de la inteligencia artificial generativa en el debate público desalentando el accionar de terceras personas, agenciadas o no, para tales fines.

El uso de etiquetado o marca de agua aparece como una de las propuestas más indicadas, junto a la necesaria alfabetización digital, si con ello se evita la confusión y la desinformación del electorado, ya que el recurso satírico, a la luz de la experiencia extranjera (California) como doméstica debe quedar extramuros de la regulación punitiva al tratarse de una forma de expresión artística con sentido crítico de aspectos esenciales y funcionales en la vida institucional de una nación, cuyo contenido escapa de la larga sombra de la censura previa que siempre oficia sus buenos servicios para los gobiernos dictatoriales.[44]

La discusión política en la República Argentina, aunque es algo universal, transcurre en 280 caracteres, en donde desde la primera magistratura hasta los funcionarios de alto nivel discuten con los opositores sobre asuntos de interés público o simplemente lo utilizan como una herramienta exclusiva y extensiva del ejercicio de la política, aunque sus resultados no siempre son los esperados. Lo más preocupante se sitúa, a nuestro juicio, cuando partidarios de tal o cual agrupación política naturalizan el uso de las “deep fakes” para enturbiar el proceso electoral, algo que debe ser evitado a toda costa, ya que la transparencia en el debate político coadyuva de manera decidida para la valoración por parte de los electores de las propuestas de cada sector en aras de fortalecer el sistema democrático, en lugar de socavar sus cimientos mediante la creación de una mentira disfrazada como verdadera.

Citas

[1] Doctor en Derecho (UNED- Madrid). Defensor de Cámara de Casación y Apelaciones en lo Penal, Penal Juvenil, Contravencional y de Faltas del Poder Judicial de la Ciudad Autónoma de Buenos Aires. Profesor de posgrado de Derecho Penal (UBA, Austral, Belgrano, Nacional de Nordeste, Nacional de Mar del Plata, Mendoza, Tucumán y del Salvador). Profesor invitado de la Universidad de Azuay (Ecuador) y la Universidad Mayor San Andrés (Bolivia). Autor del “Código Penal de la República Argentina comentado y concordado”, 7.a ed., 2025; “Derecho penal cibernético. La cibercriminalidad y el Derecho penal en la moderna sociedad de la información y la tecnología de la comunicación ”, Bdef, Montevideo-Buenos Aires, 2017; “Ciberdelitos. Análisis doctrinario y jurisprudencial”, Vols. 1° (2023), 2° (2024) y 3° (2025), elDial, entre otras obras. Director del Suplemento de Derecho Penal y Procesal Penal de ElDial. Miembro Fundador de la Academia Argentina de Ciencias Penales.

[2] Más allá del tono crítico empleado en este trabajo sobre el uso de las redes sociales como caja de resonancia de las conductas disvaliosas que cometen sus usuarios, no podemos dejar de aclarar que su utilidad social supera con creces sus eventuales efectos negativos, en especial, debe reconocerse que los medios de comunicación digitales ampliaron los confines de las relaciones intersubjetivas y fomentaron, entre otras situaciones, las protestas políticas contra regímenes dictatoriales en algunas regiones del mundo, aunque esta circunstancia no se traduzca en la adopción de sistemas propios de sociedades más abiertas, cfr. Schiffrin, Anya, Disinformation and Democracy: The Internet transformed Protest but did not improve Democracy, Journal of International Affairs, Volume 71, Issue 1, pp. 117 y ss.

[3] Resulta harto complejo medir de manera estadística el impacto real del uso de las tecnologías emergentes en el campo de los procesos electorales con el objeto de influir o alterar los resultados de los comicios. Los estudios más recientes indican que este fenómeno va cobrando mayor relevancia con el transcurso del tiempo, pero que se complementa con otros factores motivacionales como la falta de información, la desinformación intencional, la necesidad de alfabetización digital y la comunicación deficiente de las propuestas electorales, cfr. Alberto Acerbi, Sacha Altay and Hugo Mercier, Fighting misinformation or fighting for information?, Harvard Kennedy School Misinformation Review, January 2022, Volume 3, Issue 1 (https://doi.org/10.37016/mr-2020-87).

[4] Jungherr, Andreas/Schroeder, Ralph, Disinformation and the Structural Transformations of the Public Arena: Addressing the Actual Challenges to Democracy, Social Media + Society, January-March 2021, pp. 1 y ss.

[5] Labuz, Mateuz/Nehring, Christopher, On the way to deep fake democracy? Deep fakes in election campaigns in 2023, European Political Science, April 2024 (https://doi.org/10.1057/s41304-024-00482-9).

[6] Cámara Nacional Electoral, Sala Penal, expte. N° CNE 6120/2021/CA1, “Villaver, María Victoria s/ infracción ley 19.945”, de 15/7/2025.

[7] Artículo 140. – Inducción con engaños. Se impondrá prisión de dos meses a dos años al que con engaños indujere a otro a sufragar en determinada forma o a abstenerse de hacerlo.

[8] CSJN, CNE 005653/2017/CS00, “Vamos Juntos Capital Federal y otro s/ Proclamación de candidatos. Elecciones primarias”, de 25/11/2021 (Fallos: 344:3551); CNE 010566/2017/2/CS001, “Agrupación Política: Frente Cambiemos La Pampa s/ Cuestiones de competencia”, de 30/9/2021 (Fallos: 344:2513); R. 369. XLIX. REX, “Rizzo, Jorge Gabriel (apod. lista 3 Gente de Derecho) s/acción de amparo c/ Poder Ejecutivo Nacional Ley 26855 s/medida cautelar”, de 18/6/2013 (Fallos: 336:760); M. 1590. XLIII. REX, “Mendoza, Mario Raúl s/ Nulidad de mesas Frente por la Paz y la Justicia”, de 23/4/2008 (Fallos: 331:866).

[9] Tribunal Administrativo Federal alemán (Bundesverwaltungsgericht o BVerwG) 6 C 8/21 – Sentencia de 26/4/2023 (OVG Münster).

[10] El intento de alterar el resultado del escrutinio público es una vieja fórmula utilizada por los gobiernos dictatoriales para anular la voluntad popular y perpetuar el abuso del poder, cfr. BGH 3 StR 319/92 – Sentencia de 26/11/1992 (Tribunal de Distrito de Dresde) y BGH 3 StR 62/94 – Sentencia de 3/11/1994 (LG Dresden). En esta sentencia se juzgó la inducción a error y fraude electoral en los comicios celebrados en la ciudad de Dresde en 1989 durante la dictadura comunista en la denominada República Democrática alemana.

[11] CSJN, CSJ 922/2023, “Confederación Frente Amplio Formoseño c/ Formosa, Provincia de s/ Amparo”, de 19/12/2024 (Fallos: 347:2044); CSJ 561/2023, “Evolución Liberal y otro c/ San Juan, Provincia de s/ Amparo”, de 1/06/2023 (Fallos: 346:543), entre otros.

[12] Existen estudios que se han preocupado por medir de manera estadística el grado de influencia de las “deep fakes” en la sociedad estadounidense en función de los niveles etarios y canales de comunicación, concluyendo que el impacto presumido no alcanza la magnitud como para comprometer el debate público, cfr. Allen, J., Howland, B., Mobius, M., Rothschild, D., & Watts, D. J. (2020). Evaluating the fake news problem at the scale of the information ecosystem. Science Advances, Volume 6, Issue 14 (DOI: 10.1126/sciadv.aay3539).

[13] Sobre la problemática de la regulación de los delitos de peligro abstracto, cfr. Roxin, Claus/Greco, Luis, Strafrecht. Allgemeiner Teil. Band I. Grundlagen. Der Aufbau der Verbrechenslehre, 5. Auflage, C. H. Beck, München, 2020, marg. 68 y ss.

[14] Chesney, Robert/Citron, Danielle, Deepfakes and the New Disinformation War: The Coming Age of Post-Truth Geopolitics, Foreign Affairs, Volume 98, Issue 1 (January/February 2019), pp. 148 y ss.; Smith, Hannah, and Katherine Mansted. “What’s a Deep Fake?” Weaponised Deep Fakes: National Security and Democracy. Australian Strategic Policy Institute, 2020. http://www.jstor.org/stable/resrep25129.6.

[15] Chesney/Citron, Deepfakes and the New Disinformation War: The Coming Age of Post-Truth Geopolitics, pp. 150 y ss. En este artículo se asume que agentes extranjeros actuaron de manera coordinada para esparcir información falsa en las redes sociales sobre el candidato demócrata y así favorecer la elección de Donald Trump en 2016. Según los autores, la campaña de desinformación tuvo múltiples puntos de apoyo, en especial, se exacerbó la división en la sociedad bajo el uso de estereotipos raciales y llamados a la violencia colectiva. Sin embargo, el informe especial elaborado por el Departamento de Justicia de los Estados Unidos de 2019, conocido como “Informe Mueller”, descartó cualquier tipo de conexión entre el actual presidente o miembros de su grupo con la actuación de los hackers rusos que promovieron la campaña de desinformación en contra de la por entonces candidata demócrata Hillary Clinton, aunque el informe generó agudas controversias, cfr. Special Counsel Robert S. Mueller, III, U.S. Dep’t of Justice, Report On The Investigation Into Russian Interference In The 2016 Election Vol. I, 1-5 (2019).

[16] CIV 063667/2012/CS001, “Pando de Mercado, María Cecilia c/ Gente Grossa S.R.L. s/ daños y perjuicios”, de 22/12/2020 (Fallos: 343:2211); C. 57. XXXI y C. 68. XXXI, “Cancela, Omar Jesús c/ Artear SAI. y otros”, de 29/9/1998 (Fallos: 321:2637).

[17] Se desprende de los hechos descritos que el demandado es un conocido influyente (“influencer”) que tiene alrededor de 80.000 seguidores en su cuenta social de X y 360.000 suscripciones en YouTube.

[18] Kohls v. Bonta, 752 F. Supp. 3d 1187 – Dist. Court, ED California 2024.

[19] Time, Underwhelming Impact on the 2024 Elections, by Andrew R. Chow, october, 30, 2024.

[20] Nadal Lluis de/Jančárik, Peter, Beyond the deepfake hype: AI, democracy, and “the Slovak case”, Harvard Kennedy School Misinformation Review, August 2024, Volume 5, Issue 4, pp. 1 y ss.

[21] Special Counsel Robert S. Mueller, III, U.S. Dep’t of Justice, Report On The Investigation Into Russian Interference In The 2016 Election Vol. I, 1-5 (2019). Es justo también reconocer que la candidata demócrata cometió distintos errores durante la campaña, algunos de ellos que infringen leyes sobre seguridad nacional, en especial, cuando utilizó su cuenta personal para transmitir información clasificada en lugar de emplear la cuenta gubernamental especialmente creada para tal fin.

[22] Existe extensa literatura sobre la influencia de las redes sociales en el proceso de desinformación evidenciado sobre los procesos eleccionarios, cfr., por todos, Fischer, Max, Las redes del caos, traducción Barcelona, 2024, pp. 14 y ss., pp.155 y ss. No cabe duda que el medio digital utilizado por el actual presidente de los Estados Unidos desde hace tiempo inauguró una nueva forma de hacer política más directa y concentrada en sus seguidores, algo que ha sido criticado hasta el hartazgo, pero si bien la comunicación directa, sin intermediarios, resulta atractiva como una herramienta de comunicación social, lo cierto es que muchas veces los mismos políticos no tienen una acertada dimensión del efecto negativo que pueden provocar sus expresiones en algunos caracteres, en especial, cuando se propone una versión irreductible de la realidad social, económica y política que alimenta la imaginación colectiva de una realidad unidimensional en la que no cabe otro argumento o explicación que no sea el que se origina en las palabras del líder político cuya simpatías se profesa de modo acrítico. Huelga advertir sobre el peligro que se cierne sobre el sistema democrático y pluralista cuando las plataformas sociales son utilizadas de manera distorsiva para promover el mesianismo carismático, del cual existen en la historia de la humanidad reciente sobradas experiencias catastróficas. Al respecto, sobre la crítica del discurso extremista en la política estadounidense, cfr. Polak, Sara, ‘#Unpresidented’: The Making of The First Twitter President, pp. 65 y ss. y Olson, Greta, Love and Hate Online: Affective Politics in the Era of Trump, pp. 153 y ss., pp. 159 y ss. , ambas en Violence and Trolling on Social Media: History, Affect, and Effects of Online Vitriol, Amsterdam University Press, 2020.

[23] Chesney/Citron, Deepfakes and the New Disinformation War: The Coming Age of Post-Truth Geopolitics, p. 152.

[24] BBC News, Wendling, Mike, Cómo el caso Epstein está dividiendo a los simpatizantes de Trump que creen en teorías conspirativas, de 25/7/2025.

[25] Helmus, T. C., Artificial Intelligence, Deepfakes, and Disinformation: A Primer. Rand Corporation, 2022 (http://www.jstor.org/stable/resrep42027), pp. 2 y ss. Sin embargo, no cabe construir una regla de esto, ya que la alteración de la representación puede consistir en ralentizar el discurso del afectado, por ejemplo, como aconteció en 2019 con la presentación efectuada por la entonces vocera presidencial Nancy Pelosi que aparecía hablando de manera pausada y daba la impresión de estar bajo la influencia de una intoxicación alcohólica. Esta representación modificada no insumió demasiado dinero para su producción, pero causó el efecto negativo esperado en la opinión pública.

[26] Federal Communications Commission (FCC) News, Washington, May 23, 2024.

[27] Max Weiss, Max, Replication Data for: Deepfake Bot Submissions to Federal Public Comment Websites Cannot Be Distinguished from Human Submissions, https://doi.org/10.7910/DVN/OQCPOT, Harvard Dataverse, V1, 2019.

[28] C/2024/3014. Diario Oficial de la Unión Europea, Serie C, de 26/4/2024.

[29] https://cmp.eui.eu/media-pluralism-monitor-2024.

[30] Diario Oficial de la Unión Europea, 7/19.

[31] Ice, Jessica, “Defamatory Political Deepfakes and the First Amendment”, Case Western Reserve Law Review, Volume 70, Issue 2 (2019), pp. 429 y ss.; Lecher, Colin, “California has Banned Political Deepfakes During Election Season”, Verge (Oct. 7, 2019), https://www.theverge.com/2019/10/7/20902884/california-deepfake-political-ban-election-2020 [https://perma.cc/ 88Y7-4AA2]. También optó por este sendero prohibitivo el estado de Virginia, cfr. Robertson, Adi, “Virginia’s ‘revenge porn’ laws now officially cover deepfakes”, Verge, (Jul. 1, 2019), https://www.theverge.com/2019/7/1/20677800/virginia-revenge-porn-deepfakes-nonconsensual-photos-videos-ban-goes-into-effect.

[32] HR5586 – DEEPFAKES Accountability Act118th Congress (2023-2024). Este proyecto de ley define a las “deepfakes” como “cualquier grabación de video, película, grabación de sonido, imagen electrónica o fotografía, o cualquier representación tecnológica del discurso o conducta que se derive sustancialmente de los mismos: (A) que parezca representar auténticamente cualquier discurso o conducta de una persona que de hecho no participó en dicho discurso o conducta; y B) cuya producción dependiera sustancialmente de medios técnicos, más que de la capacidad de otra persona para hacerse pasar física o verbalmente por esa persona.” [“(3) DEEPFAKE.—The term ‘deepfake’ means any video recording, motion-picture film, sound recording, electronic image, or photograph, or any technological representation of speech or conduct substantially derivative thereof— (A) which appears to authentically depict any speech or conduct of a person who did not in fact engage in such speech or conduct; and (B) the production of which was substantially dependent upon technical means, rather than the ability of another person to physically or verbally impersonate such person]. En este sentido, Brown, Nina I., “Deepfakes and the Weaponization of Disinformation”, Virginia Journal of Law & Technology, Volume 23, N° 1 (2020), pp. 1 y ss.; pp. 23 y ss.

[33] Barrett, Bridget/Kreiss, Daniel, Platform transience: changes in Facebook’s policies, procedures, and affordances in global electoral politics, Internet Policy Review, Volume 8, Issue 4 (2019), (https://doi.org/10.14763/2019.4.1446).

[34] Tribunal Electoral CABA, expte. n° 78.728/2025-0 CUIJ J-01-00078728-7/2025, Protocolo N° 89/2025, “Jarvis, Ezequiel E. sobre causas electorales . otros electores”, de 18/5/2025.

[35] Aboso, Gustavo E., Código Contravencional y Procedimiento de la Ciudad Autónoma de Buenos Aires, 3.a ed., Bdef, Montevideo-Buenos Aires, 2022, comentario del artículo 15, pp. 126 y ss.

[36] BGH 3 StR 62/94 – Sentencia de 3/11/1994 (LG Dresden).

[37] Fischer, Thomas, Strafgesetzbuch mit Nebengesetzen, 69. Auflage, C. H. Beck. München, 2022, § 108a.

[38] Sieber, Ulrich, Straftaten und Strafverfolgung im Internet, Gutachten C zum 69. Deutschen Juristentag, Beck, München, 2012, C 88; Hilgendorf, Eric/Frank, Thomas/Valerius, Brian, Computer-und Internetstrafrecht, Springer, Berlin, 2005, marg. 6. En este sentido, Aboso, Gustavo E., Derecho penal cibernético, Bdef, Montevideo-Buenos Aires, 2017, pp. 17 y ss.

[39] Citron, Danielle K./Chesney, Robert, Deep Fakes: A Looming Challenge for Privacy, Democracy, and National Security, California Law Review, Volume 107 (2019), pp. 1817 y ss. Estos autores proponen, entre otras cosas, que sean los propios proveedores del servicio digital los que ejerzan el control sobre los contenidos difundidos a través de sus plataformas sobre la base de las condiciones de servicio (terms of service o TOS). El contrato de servicio digital es un instrumento útil para establecer un límite en el uso de las plataformas, en especial, cuando la conducta es objetivamente delictiva, por ejemplo, cuando se la utiliza para la distribución de material de abuso sexual infantil o como canal de comunicación de los discursos de odio, pero se plantean dudas razonables cuando se propone extender el control de los administradores al contenido político, en especial, el satírico. El peligro latente de crear una instancia de control de los contenidos o una suerte de censura previa ejercida por las corporaciones tecnológicas abre un capítulo oscuro e incierto para la libertad de expresión, ya que mientras los gobiernos lo tienen vedado constitucionalmente, dejaríamos en mano de una dictadura corporativa qué es lo que se puede comunicar y qué no. Podría abrirse un sendero sinuoso para una nueva forma de totalitarismo digital que es un peligro que no debe ser subestimado cuando la infraestructura crítica queda en manos de pocas empresas informáticas, cuyos abusos están bien documentados, en especial, con la violación a la privacidad en el uso de datos personales aplicados a la llamada “minería de datos” con fines comerciales, cfr. Zuboff, Shoshana, La era del capitalismo de la vigilancia, Paidós, Barcelona, 2020, pp. 83 y ss.

[40] “Toda censura previa que se ejerza sobre la libertad de expresión padece de una fuerte presunción de inconstitucionalidad y, por ende, la carga argumentativa y probatoria de su necesidad pesará sobre quien invoca dicha restricción” expresó nuestra máxima instancia judicial a nivel federal en el proceso civil sustanciado contra los motores de búsqueda que indexan contenido sobre la demandante de hecho pretéritos que suscitaron el interés público, CSJN, CIV 050016/2016/CS001, “DeNegri, Natalia Ruth c( Google Inc. s/ Derechos personalísimos: acciones relacionadas”, de 28/6/2022 (Fallos: 345:482). En igual sentido, en materia de medios digitales, Fallos: 342:2187. También la Corte Suprema de Justicia de la Nación recurrió de manera reiterada al concepto de censura previa y su incompatibilidad con el sistema democrático al obstaculizar el debate público de ideas que caracteriza a una sociedad libre y democrática, Fallos: 330:4615; 330:3908; 324:2895 (voto del juez Belluscio); 321:2848; 321:2558; entre otros: salvo que el contenido versara sobre aspectos de la vida privada de un menor de edad, Fallos: 330:3685; 324:975.

[41] Esta solución alternativa o conjunta puede resultar meramente simbólica, ya que los administradores de las plataformas de las principales redes sociales rara vez ejercen un control efectivo sobre los contenidos como está sobradamente documentado en el caso de Facebook y los discursos de odio, por ejemplo, la eliminación de posteos de políticos que exhortan al uso de la fuerza armada, cfr. Fisher, Las redes del caos, pp. 438 y ss. que describe la huelga desarrollada por los empleados de Facebook luego de registrarse hechos criminales contra las fuerzas del orden por parte de activistas extremistas cuyas acciones estuvieron promovidas a través de los grupos sociales y el uso de algoritmos que potenciaban la escalada de la lucha racial y los mensajes violentos. El trasfondo de la medida de fuerza laboral estuvo signada por el asesinato de un agente federal y las heridas provocadas a otro durante una marcha de protesta contra la represión policial en San Francisco. El autor de los disparos mediante el uso de un rifle de asalto, que había pertenecido al ejército de ese país, aprovechó el desarrollo de la manifestación para generar una escalada de violencia contra los protestantes. El acusado y finalmente condenado admitió que participó de manera activa en las redes sociales apadrinadas por movimientos extremistas racistas (movimiento Boogaloo) que hacían de la apología de la violencia su credo y promovían la difusión de teorías conspirativas sobre la restricción de las libertades civiles por parte de agencias federales, en especial, durante el confinamiento obligatorio de 2020.

[42] El proyecto 2536-D-2025, de 21/5/2025, está firmado por Julio C. Cobos, Margarita Stolbizer, Marcela Coli, Melina Giorgi, Atilio Benedetti, Mario Barletta, entre otros legisladores.

[43] Gehringer, Ferdinand/Nehring, Christopher/Labuz, Matheus, The Influences of Deep Fakes on Elections, Berlin, May 2024 Analysis and Consulting, Konrad Adenauer Stiftung, pp. 1 y ss. En este informe se enfatiza que el número de incidentes mediante el uso de contenido sintético se incrementó de manera exponencial en las últimas elecciones celebradas en distintos países y su objetivo principal fue el de desacreditar al oponente político de turno mediante la desinformación. Se citan ejemplos del uso de la IA generativa como lo son el de Turquía en el que uno de los candidatos renunció a su postulación cuando apareció representado en un vídeo sexual alterado (mayo 2023) y el de la República Argentina con el uso de contenido sintético de uno de los candidatos en el que aparecía retratado en un poster con reminiscencias del pasado asociado a la propaganda soviética, aunque huelga aclarar que en este caso no hubo un uso malicioso para agredir o desacreditar a los demás candidatos. A su vez, en un posteo en la red X de la cuenta del por entonces candidato, actual presidente, se exhibió un fotomontaje en el que aparecía Massa como Mao Tse-Tung que alcanzó los tres millones de visualizaciones (cfr. Nicas, Jack/Cholakian Herrera, Lucía, Is Argentina the First A.I. Election?, The New York Times, November 15, 2023, nytimes.com).

[44] “La sátira como forma de discurso crítico se caracteriza por exagerar y deformar agudamente la realidad de modo burlesco, indefectiblemente genera en quien lo lee u observa la percepción de algo que no es verídico o exacto y el tono o forma socarrona, punzante, virulenta o agresiva que se utiliza para transmitirlo provoca en el receptor del discurso crítico risa, sorpresa, estupor, rabia, agitación, bronca, pudiendo abordar bajo esa metodología temas de los más variados, religiosos, sociales, políticos, económicos, culturales”, cfr. CSJN, CIV 063667/2012/CS001, Pando de Mercado, María Cecilia c/ Gente Grossa S.R.L. s/ daños y perjuicios, de 22/12/2020 (Fallos:343:2211).

Buscar

Edición

Diciembre de 2025

Marzo de 2025

15 de diciembre de 2024

Edición Especial

Derecho Penal y Criminología

Alberto Pravia, Director

15 de julio de 2024

20 de diciembre de 2023

15 de julio de 2023

20 de diciembre de 2022

15 de junio de 2022

Sobre la Revista

Capacitaciones Recomendadas

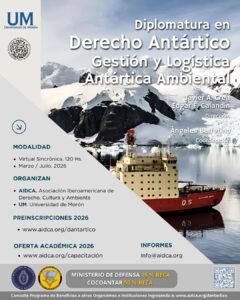

Diplomatura en

Derecho Antártico, Gestión y

Logística Antártica Ambiental

AIDCA – Universidad de Morón

Dirección: Dr. Javier A. Crea y

GB (R) Edgar Calandín

Coordinación: Dra. María de

los Ángeles Berretino

Modalidad: Virtual

Publicaciones Recomendadas

Javier Alejandro Crea

María de los Ángeles

Berretino

Tratado de Derecho Antártico.

La gestión polar ambiental en

el marco de los Derechos

Humanos

Javier A. Crea

Mauricio H. Libster

Derecho Penal Ambiental.

El Acceso a la Justicia y la

integración a los Objetivos del

Desarollo